Correr modelos de IA generativa en local... FACIL

La inteligencia artificial generativa ha llegado para quedarse y para ser utilizada masivamente en un futuro que nadie se atreve a vaticinar.

Dichos modelos se dividen en los gigantescos monstruos detrás de ChatGPT o similares, los llamados LLM (Modelos Grandes de Lenguaje), y los pequeños SLM que se pueden correr incluso en máquinas locales como el portátil desde donde escribo estas líneas.

Microsoft, como una de las empresas que antes y con más fuerza ha apostado por esta “mágica” tecnología, ha hecho evolucionar su plataforma de inteligencia artificial a un excelente servicio llamado AI Foundry, en donde tenemos miles de modelos de todo tamaño, fabricante, y utilidad para ser consumidos de acuerdo con el tamaño de nuestra billetera.

Azure AI Foundry

Es un servicio excelente, del cual imparto el curso de certificación AI-102, que uso a diario para resolver aquellas dudas que agotan a un ChatGPT gratuito rápidamente, y del cual acaba de publicar Microsoft un minitutorial de la ejecución de todo un AI Foundry pero en local. Permitiendo correr modelos pequeñitos, de los miles que hay en el catálogo, incluso en un portátil que tiene una Nvidia 5060 RTX de 8Gb., Ryzen 7, y 16Gb de RAM DDR5. Es decir, un poquito menos de 1.000€.

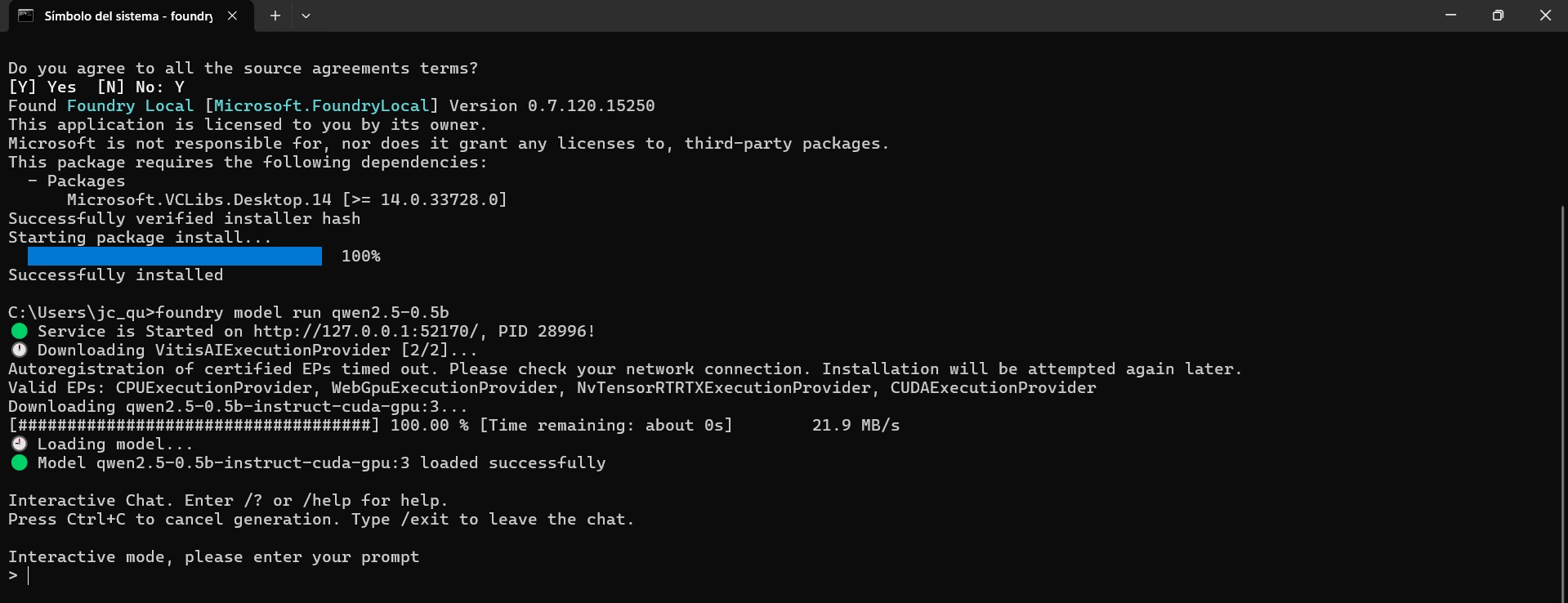

Y lo más alucinante es que, literalmente en dos pasos, ya tengo un chatbot corriendo en mi ordenador, que utiliza un SLM Qwen 2 5-0 5b para contestar de una forma más que decente.

Pruébalo. Funciona en prácticamente cualquier tarjeta gráfica que tenga menos de 7 años (serie 2000 de las RTX o coetánea). Y te puede abrir un mundo nuevo en donde están surgiendo proyectos y capacidades alucinantes.

Por otro lado, me he pasado un tiempecito trasteando con el modelo… y es bastante tontuno. Pero bastante. Aún así, seguro que puedo utilizar modelos más completos, y me gustaría probar RAG o generación de imágenes.

¡Cuanto por aprender!